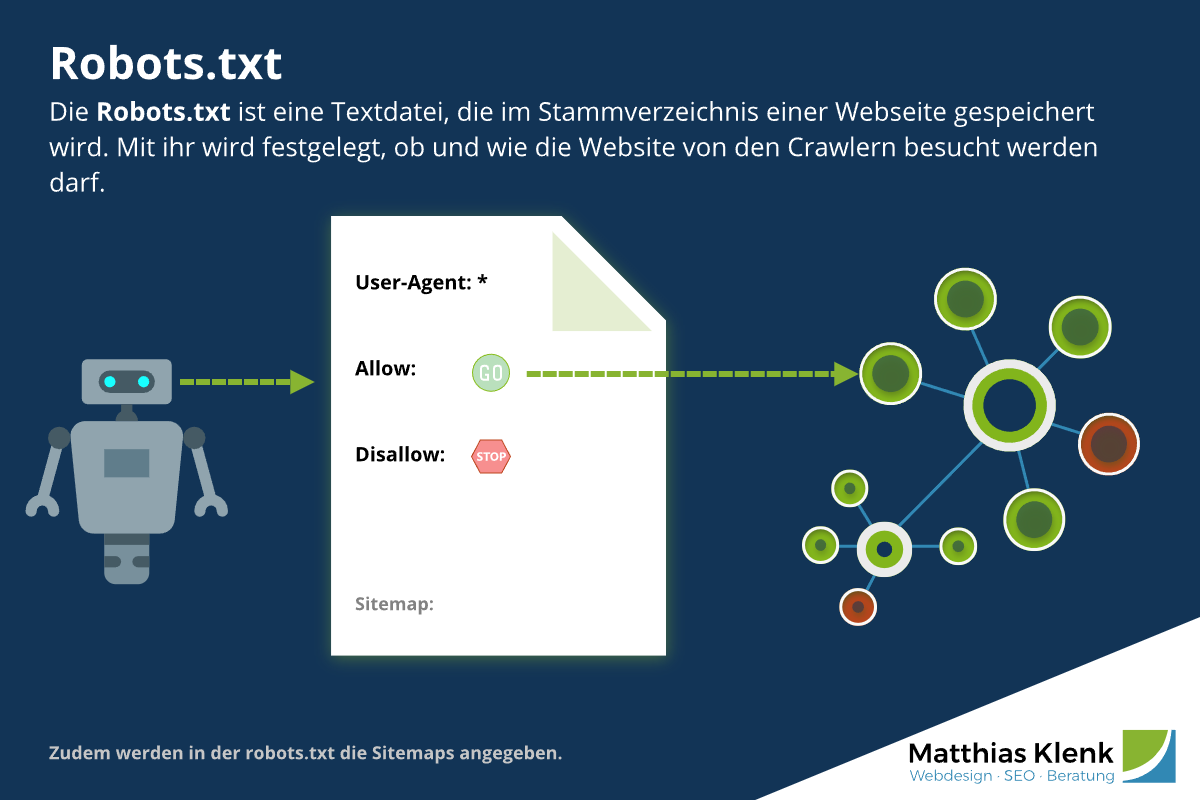

Robots.txt

Die robots.txt ist eine unscheinbare, aber sehr wichtige Datei für jede Website. Sie steuert, welche Inhalte von Suchmaschinen-Crawlern und künstlicher Intelligenz (KI / AI) erfasst und indexiert werden dürfen – und welche nicht.

Dieser Beitrag erklärt die Grundlagen, den Aufbau und die Bedeutung der robots.txt für SEO und Google-Indexierung – kompakt und praxisnah.

Definition Robots.txt

Die Robots.txt ist eine Textdatei, die auf dem Server einer Website gespeichert wird. Mit ihr wird festgelegt, welche Bereiche einer Website die Crawler von Suchmaschinenanbietern besuchen, erfassen, bewerten und indexieren dürfen.

Grundlegende Syntax der robots.txt

Die robots.txt-Datei besteht aus Anweisungen, die in Gruppen zusammengefasst sind. Jede Gruppe beginnt mit einem spezifischen User-agent und enthält eine oder mehrere Disallow- oder Allow-Regeln.

| Direktive | Erklärung | |

| User-agent | Definiert, für welchen Crawler (Bot) die nachfolgenden Regeln gelten. * (ein Sternchen) steht für alle Crawler. | |

| Disallow | Verbietet das Crawlen des angegebenen Pfades. Ein leerer Disallow-Eintrag erlaubt alles. | |

| Allow | Erlaubt das Crawlen eines Pfades, auch wenn dessen übergeordnetes Verzeichnis verboten ist. | |

| Sitemap | (Optional, aber empfohlen) Gibt den vollständigen Pfad zur XML-Sitemap an, um Crawlern die Entdeckung wichtiger URLs zu erleichtern. |

Hinweis: Crawler können die robots IGNORIEREN

Da einige Suchmaschinen die robots.txt-Datei (auch Robots-Exclusion-Standard-Protokoll genannt) ignorieren, sollten Unterseiten, die geheime oder nicht-öffentliche Informationen enthalten, mit einen Passwort geschützt werden, damit sie nicht in den SERPs (Suchergebnisseiten) der Anbieter erscheinen.

Die robots.txt überprüfen

Mit dem Robots.txt-Tester können Sie Ihre Robots direkt online überprüfen. Kostenfrei und ohne Speicherung Ihrer Daten.

Die robots.txt in Zeiten von KI und AI

Mit dem Aufkommen von KI-basierten Suchsystemen und Webcrawlern, wie etwa ChatGPT, Google Gemini oder Bing Copilot, gewinnt die robots.txt neue Bedeutung.

Viele dieser Systeme nutzen Website-Inhalte nicht nur für Crawling und Indexierung, sondern auch zum Trainieren von KI-Modellen oder zur Beantwortung von Nutzeranfragen direkt in Suchergebnissen.

Daher ist es für Websitebetreiber wichtig, über die robots.txt festzulegen, welche Inhalte von KI-Crawlern verarbeitet oder ausgeschlossen werden dürfen.

Google und OpenAI respektieren in der Regel die robots.txt-Richtlinien (z. B. über den Eintrag User-agent: GPTBot oder User-agent: Google-Extended). So können Websitebetreiber gezielt steuern, XXX ob ihre Inhalte für KI-Training oder generative Suchergebnisse genutzt werden dürfen.

Tipp: Prüfen Sie regelmäßig, welche neuen AI-Crawler aktiv sind, und aktualisieren Sie die robots.txt entsprechend, um Kontrolle über die Nutzung Ihrer Inhalte zu behalten.

robots.txt - Häufige Fragen & Antworten

Wo wird die robots.txt hinterlegt?

Die Datei ist im Stammverzeichnis (Root Directory) einer Webseite untergebracht und die erste Datei, die von Robots, Crawlern oder Spidern gelesen wird.

Die liegt hier bspw. unter:

https://www.matthiasklenk.de/robots.txt

Tipp: Ihr Unternehmen braucht SEO-Unterstützung? Ich analysiere, berate und optimiere direkt.

Lassen Sie uns in einem unverbindlichen Erstgespräch über Ihr Projekt sprechen.

Was muss in der Robots txt stehen?

Es muss Nichts in der robotx.txt stehen. Bei einer Website die bspw. lediglich aus einer index.html besteht wäre das sinnfrei.

Allerdings nutzen die meisten Content-Management-Systeme bestimmte Ordner für temporäre- oder Cache-Dateien. Um das Crawlbudget nicht zu strapazieren und sinnlose Inhalte auffindbar zu machen sollten solche Ordner per Disallow ausgeschlossen werden.

Ist die robots.txt wichtig für SEO?

Ja. Die robots.txt muss korrekt konfiguriert sein.

Sollte Google hier Probleme entdecken werden diese jedoch in der Google Search Console angezeigt.

Mögliche Fehlermeldungen in der Search Console:

"Durch robots.txt-Datei blockiert"

"Indexiert, obwohl durch robots.txt-Datei blockiert"

Weiterführende Infos:

Robots txt Tester in der Search Console von Google: support.google.com/webmasters/answer/6062598?hl=de

Eine aktualisierte Robots.txt einreichen: developers.google.com/search/docs/crawling-indexing/robots/submit-updated-robots-txt?hl=de

Allgemeine Infos zu Robots.txt: developers.google.com/search/docs/crawling-indexing/robots/intro?hl=de

Sehen Sie die robots.txt nicht als Mittel zur Entfernung von Inhalten aus dem Index, sondern als Werkzeug zur Steuerung der Crawler und dem dait verbundenen Verkehr und zur Optimierung Ihres Crawl-Budgets. Eine saubere Konfiguration ist ein extrem wichtiger Bestandteil der technischen SEO.

Überprüfen Sie Ihre robots.txt regelmäßig, insbesondere nach einem Relaunch, und nutzen Sie den robots.txt-Tester in der Google Search Console, um sicherzustellen, dass Ihre Angaben und Anweisungen wie beabsichtigt funktionieren.

Keine Ressourcen verfügbar im Unternehmen? Gerne übernehme ich die Optimierung der robots.txt als Teil einer SEO-Betreuung oder direkt als SEO-Freelancer.

Sie möchten unverbindlich über eine Zusammenarbeit sprechen?

Vereinbaren Sie gerne ein Erstgespräch.