Disallow in der robots.txt und dem Tag robots Noindex?

Was ist der Unterschied zwischen Disallow in der robots.txt und dem Tag robots Noindex?

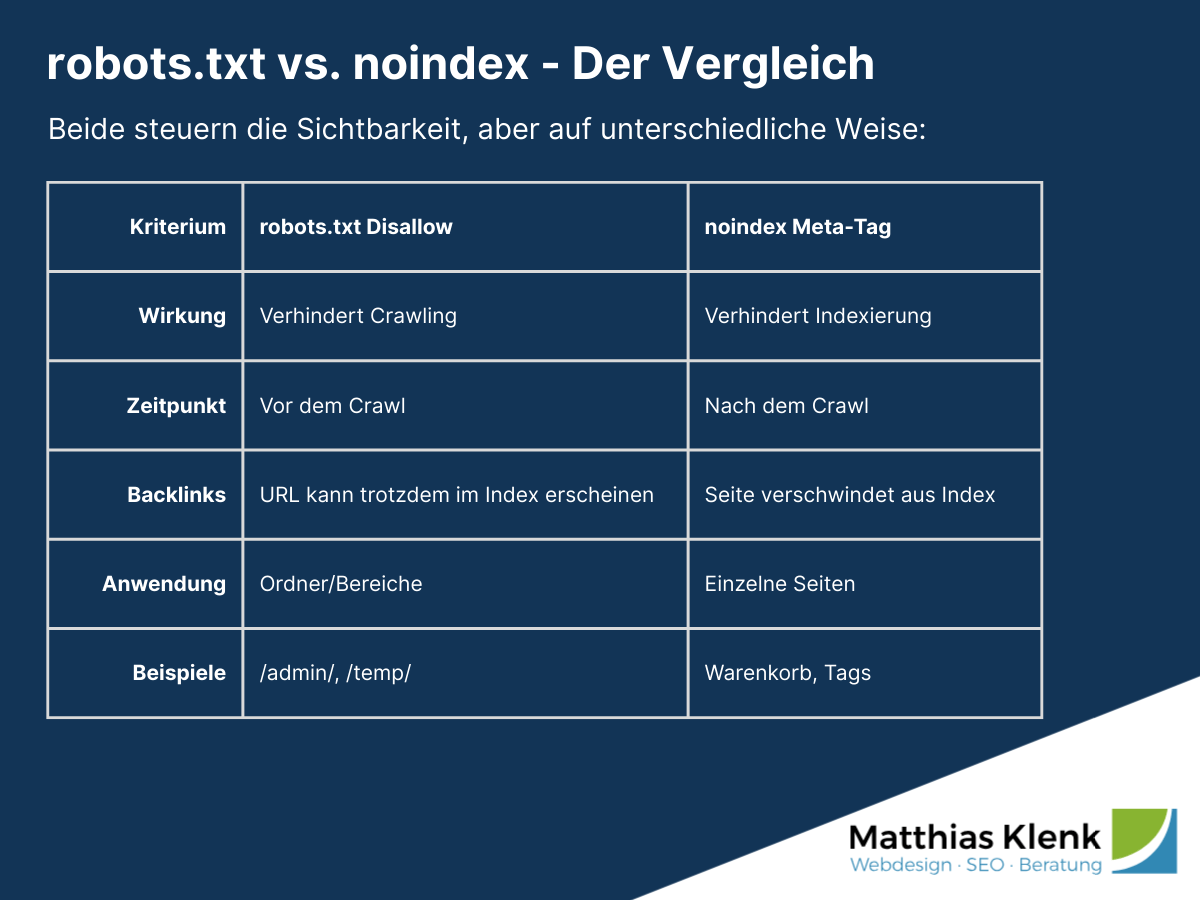

Wer eine Website betreibt und sich mit Crawling und Indexierung durch Google beschäftigt, kommt an den Themen robots.txt, noindex, Crawl Budget, etc. nicht vorbei. In diesem Zusammenhang sind die robots.txt und das Meta-Tag "robots" von Bedeutung. Der wesentliche Unterschied besteht im Zeitpunkt des Wirkens der beiden Angaben.

Die Angabe "Disallow" in der robots.txt verbietet den Crawlern, wie etwa dem Google Crawler oder auch diverse SEO Tools, in den jeweiligen „Bereich“ der Webseite einzudringen und die dortigen Inhalte zu crawlen.

Die Angabe robots noindex hingegen ist auf Seitenebene zu betrachten, wobei hier bspw. einzelne, wenig relevante Seiten auf noindex gesetzt werden können.

Wann verwende ich Disallow in der robots.txt?

Ordner mit temporären Dateien

Ein Beispiel für die Verwendung von Disallow in der robots.txt sind Ordner mit temporären Dateien.

Disallow: /temp/

Loginbereich

Ein weiteres Beispiel ist eine Loginbereich der nur bestimmten Nutzern zugänglich ist und nicht gleichzeitig eine Loginseite ist.

Disallow: /login/

Probleme mit Disallow in der robots.txt

Auch wenn der jeweilige User-Agent angewiesen wird einen bestimmten Bereich nicht zu crawlen, kann ein einfacher Backlink auf eine der Seiten dazu führen, dass die URL trotzdem im Index erscheint – allerdings ohne Titel, Description oder andere Content-Informationen. Die Seite wird weiterhin nicht gecrawlt, aber Google listet die URL mit dem Hinweis "Keine Informationen über diese Seite verfügbar" im Index.

MERKE: Disallow verhindert das Crawling, aber nicht die Indexierung von URLs mit Backlinks. Für echten Ausschluss aus dem Index muss noindex verwendet werden.

Beispiel für eine Disallow Anweisung in der robots.txt:

User-agent: *

Allow: /

Disallow: /loginbereich/

Disallow: /temp/

Disallow: /admin/

Sitemap: https://www.websitexyz.de/sitemap.xml

Wo findet man die robots.txt?

Die robots.txt, als auch die sitemap.xml ist direkt im Root-Verzeichnis zu finden. Also unter meine-webseite.de/robots.txt

Wann verwende ich robots noindex Meta-Tag?

Warenkorb, Loginbereich, Schlagworte / Tags

Bereiche die wenige sinnvolle Inhalte bieten sollten durch noindex ausgeschlossen werden.

Hierzu zählen bspw. bei Onlineshops der Warenkorb, der Loginbereich und auch Seiten die durch Schlagwörter generiert werden und keinen zusätzlichen Nutzen bieten.

MERKE: Links zu noindex-Seiten sollten idealerweise komplett entfernt werden. Sind sie notwendig (z.B. für die Navigation), kann Google sie weiterhin crawlen und die noindex-Anweisung verhindert nur die Indexierung. Das Attribut nofollow ist hier nicht mehr zeitgemäß und bringt keinen SEO-Vorteil.

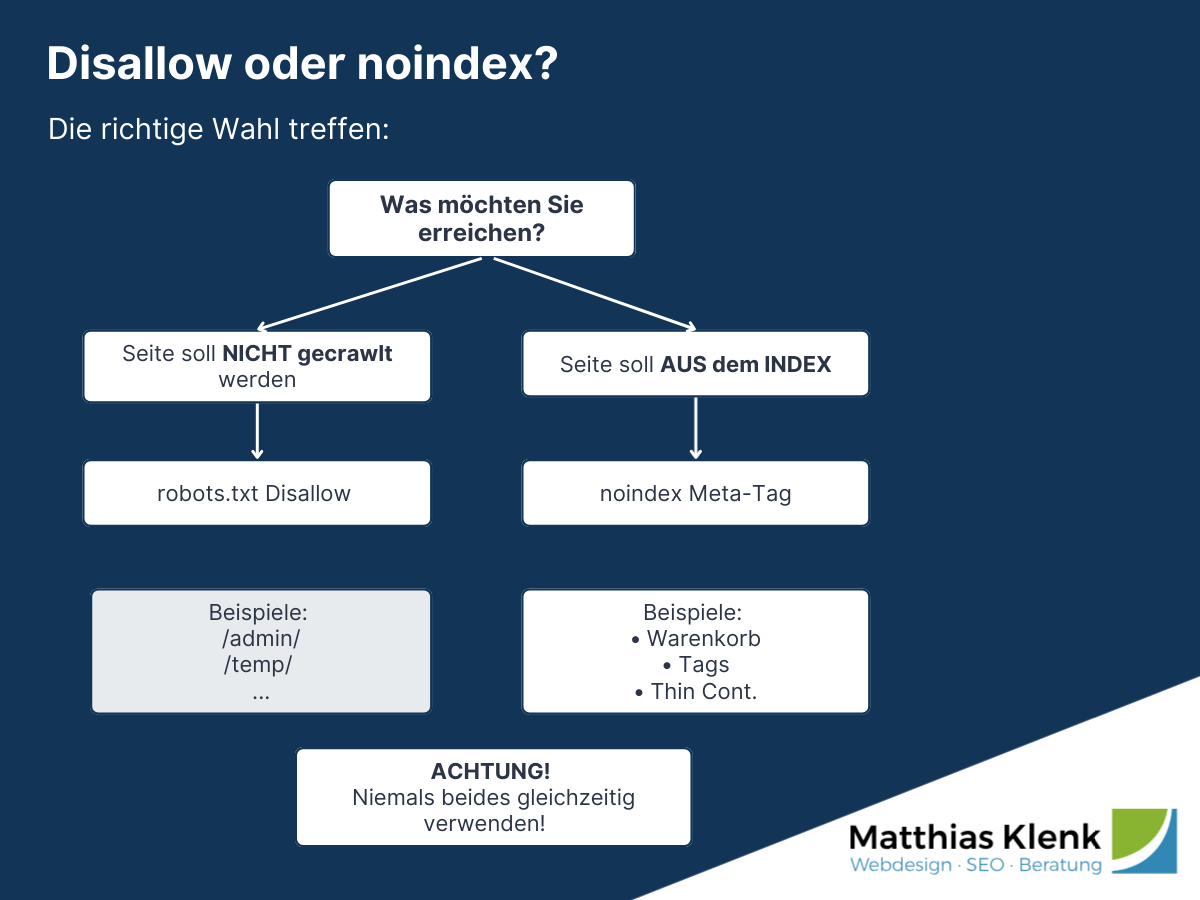

Häufiger Fehler: Kombination von Disallow UND noindex

Ein kritischer Fehler ist die gleichzeitige Verwendung von Disallow in der robots.txt UND noindex im Meta-Tag für dieselbe Seite.

Problem: Wenn Google durch Disallow am Crawlen gehindert wird, kann der Crawler das noindex-Tag auf der Seite nicht lesen. Die Seite bleibt möglicherweise im Index, wenn sie Backlinks hat.

Richtig:

- Für Ausschluss aus dem Index: noindex verwenden, robots.txt NICHT blockieren

- Für Crawl-Budget-Schonung ohne Indexierung: noindex reicht aus

- Disallow nur für Bereiche, die nie gecrawlt werden sollen (z.B. Admin, temp-Dateien)

Tipp: Ihr Unternehmen braucht SEO-Unterstützung? Ich analysiere, berate und optimiere direkt.

Lassen Sie uns in einem unverbindlichen Erstgespräch über Ihr Projekt sprechen.

Erweiterte Steuerungsmöglichkeiten

X-Robots-Tag im HTTP-Header

Alternativ zum Meta-Tag kann noindex auch per HTTP-Header gesetzt werden. Dies ist besonders nützlich für Dateitypen ohne HTML-Kopfbereich (PDFs, Bilder):

X-Robots-Tag: noindex, nofollow

Crawl-Budget-Optimierung

Bei großen Websites mit tausenden Seiten spielt das Crawl-Budget eine wichtige Rolle. Durch gezielten Einsatz von robots.txt (Disallow für unwichtige Bereiche) und noindex (für dünne Inhalte) kann gesteuert werden, welche Seiten Google bevorzugt crawlen soll.

Faustregel:

- Disallow: Technische Bereiche, die nie im Index erscheinen sollen

- Noindex: Inhalte mit geringem Mehrwert, die aber verlinkt sein können

Wie werden Seiten aus dem Google-Index entfernt?

Um bereits indexierte Seiten aus dem Google-Index zu entfernen, empfiehlt sich folgende Vorgehensweise:

Um einzelne Seiten aus dem Index von zu entfernen, darf der Zugriff in der robots.txt nicht verboten werden, und der robots Metatag muss auf noindex gesetzt werden.

Zudem sollten alle internen Links auf die zu entfernende Seite entfernt werden. Sowohl aus den eigenen Seiten als auch in der Sitemap. Für Backlinks sollten dementsprechend Weiterleitungen eingerichtet werden.

Häufige Fragen zu noindex und robots.txt

Wie lange dauert es, bis eine noindex-Seite aus dem Index verschwindet?

In der Regel dauert es einige Tage bis wenige Wochen, bis Google eine noindex-Seite aus dem Index entfernt hat. Die Dauer hängt davon ab, wie oft der Googlebot die Seite crawlt. Bei wichtigen Seiten kann der Prozess über die Google Search Console unter "Entfernen" → "Neues URL-Entfernungsanfrage" beschleunigt werden. Die Seite verschwindet dann innerhalb von 24-48 Stunden temporär aus den Suchergebnissen.

Wie kann ich prüfen, ob noindex oder robots.txt korrekt gesetzt ist?

Für noindex:

- Im Browser: Seitenquelltext aufrufen (Rechtsklick → "Seitenquelltext anzeigen") und nach

<meta name="robots" content="noindex">suchen - Google Search Console: Unter "URL-Prüfung" die entsprechende URL eingeben. Google zeigt an, ob noindex erkannt wurde

- Browser-Erweiterungen: SEO-Tools wie "SEO Meta in 1 Click" zeigen noindex-Status direkt an

Für robots.txt:

- Direkt aufrufen:

websitexyz.de/robots.txtim Browser öffnen - Google Search Console: Tool "robots.txt-Tester" nutzt, um zu prüfen, ob URLs blockiert werden

- Online-Tools: Verschiedene kostenlose robots.txt-Tester verfügbar

Häufiger Fehler: Seite ist in robots.txt auf Disallow UND hat noindex-Tag – Google kann dann das noindex-Tag nicht lesen. Lösung: Disallow entfernen.

Als SEO-Freelancer unterstütze ich auch Ihr Unternehmen mit der professioneller SEO. Gerne auch im Bereich technische SEO.

Sie möchten unverbindlich über eine Zusammenarbeit sprechen?

Vereinbaren Sie gerne ein Erstgespräch.