Warum Seiten nicht indexiert werden - Seitenindexierung in der GSC

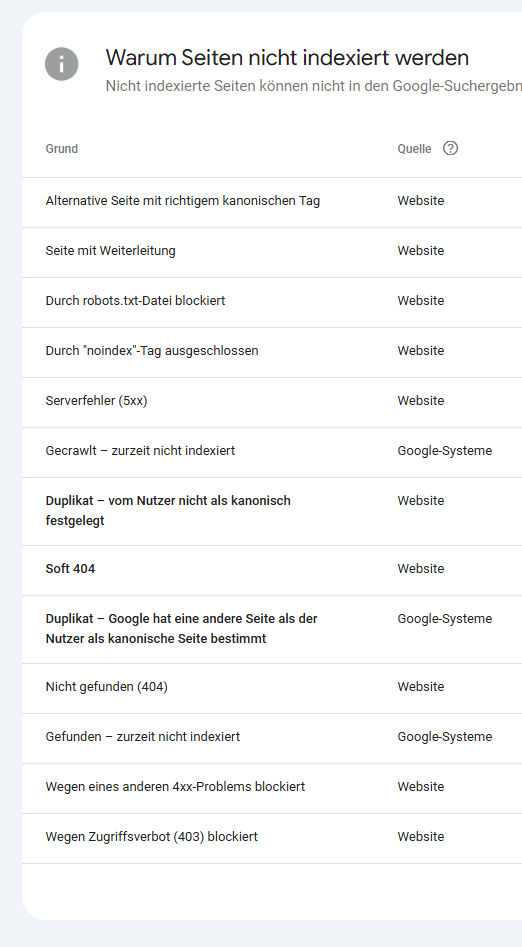

In der GSC finden Sie unter INDEXIERUNG > SEITEN den Bereich Warum Seiten nicht indexiert werden.

In diesem Beitrag erkläre ich als SEO Freelancer mit Erfahrung besonders im Bereich technischer SEO die einzelnen Fehlermeldungen und zeige auf, warum die Informationen aus der Google Search Console so relevant für das korrekte Crawling sind und letzendlich die Indexierung bei Google ist.

Hinweis: In diesem Beitrag geht es um die Fehler im Bereich Warum Seiten nicht indexiert werden in der Google Search Console und nicht um allgemeine Fehler, die die Indexierung bei Google verhindern könnten.

- Seite mit Weiterleitung

- Durch robots.txt-Datei blockiert

- Durch "noindex"-Tag ausgeschlossen

- Gecrawlt – zurzeit nicht indexiert

- Gefunden – zurzeit nicht indexiert

- Nicht gefunden (404)

- Soft 404

- Alternative Seite mit richtigem kanonischen Tag

- Wegen eines anderen 4xx-Problems blockiert

- Serverfehler (5xx)

- Duplikat – Google hat eine andere Seite als der Nutzer als kanonische Seite bestimmt

- Duplikat – vom Nutzer nicht als kanonisch festgelegt

- Wegen Zugriffsverbot (403) blockiert

- Umleitungsfehler

- Wegen nicht autorisierter Anforderung (401) blockiert

- Ihr SEO-Experte für Crawling und Co.

Seite mit Weiterleitung

Bei Seite mit Weiterleitung handelt es sich um URLs, die weitergeleitet werden. Dies kann mehrere Gründe haben. In der Regel lohnt es sich den Bereich zu kontrollieren

Mögliche Gründe für Seite mit Weiterleitung:

- URLs einer vorherigen Domain (Bspw. Nach Domainwechsel oder Relaunch)

- Spam Links (Wie aktuell die 1000 URLs)

- URLs die wirklich weitergeleitet wurden, weil es bspw. Umstrukturierung gab

- Möglich ist auch ein fehlerhafte Canonical

Seite mit Weiterleitung ist bei größeren Websites niemals leer. Irgendwelche Weiterleitungen finden die GSC immer, was allerdings eher ein Hinweis als ein Fehler ist.

Durch robots.txt-Datei blockiert

Wie man sich sicherlich schon denken kann bedeutet Durch robots.txt-Datei blockiert, dass das Crawling durch die robots.txt blockiert wird.

Hier finden sich meist URLs, wie beispielsweise:

- Subdomains die nicht für die Öffentlichkeit bestimmt sind

- Links in Online-Shop wie "add-to-cart"

- URLs mit Filter, oder Sortierungen (?category_id=123&sort_by=timestamp&sort_order=desc)

- Ganze Bereiche mit irrelevanten Dateien

Durch robots.txt-Datei blockiert ist meist mit einigen Hinweisen / URLs bestückt bei größeren Webseiten. Behalten Sie den Bereich im Auge, um mögliche Fehler in der robots.txt direkt zu erkennen und ein einwandfreies Crawling zu gewährleisten.

Durch "noindex"-Tag ausgeschlossen

Durch "noindex"-Tag ausgeschlossen bedeutet fast dasselbe wie Durch robots.txt-Datei blockiert allerdings an einer anderen Stelle. Während noindex im Head einer URL liegt (und erst erkannt wird, wenn die URL gecrawlt wird), liegt die robots.txt im Hauptverzeichnis einer Domain (https.//websitexyz.de/robots.txt) und wird regelmäßig von den Suchmaschinen gecrawlt.

Im Endeffekt sollten Sie auch diesen Bereich regelmäßig kontrollieren, um mögliche Fehler zu korrigieren.

In der Regel sollten Sie sich keine Sorgen machen bei:

- URLs mit URL-Parameter bzw. Query-Parameter.

- URLs die Sie intern nicht verlinken und die wirklich ein noindex im Head haben

Gecrawlt – zurzeit nicht indexiert

Der Hinweis Gecrawlt – zurzeit nicht indexiert zeigt Ihnen welcher Inhalt von Google zwar gecrawlt wurden, allerdings nicht gut genug sind für den Index und das folgende Ranking.

Mögliche Gründer für Gecrawlt – zurzeit nicht indexiert sind daher:

- Dünner und irrelevanter Content (Bspw.: "Wir sind in den Betriebsferien" im Blog)

- URLs, die nur dürftig intern verlinkt werden und Google als irrelevant erscheinen

- Inhalte von denen Sie ggf. keine Ahnung haben, bzw. die nicht zum restlichen Content passen

- 0815 KI Content von ChatGPT der erstellt wurde, ohne einen Mehrwert zu bieten

Google möchte den Suchenden nur gute und relevante Inhalte präsentieren. Achten Sie daher darauf, nur hochwertige und relevante Inhalte zu veröffentlichen, die einen Mehrwert bieten, die Suchintention treffen und Ihrer Expertise entsprechen.

Gefunden – zurzeit nicht indexiert

Der Hinweis Gefunden – zurzeit nicht indexiert ist der kleine Verwandte von Gecrawlt – zurzeit nicht indexiert und zeigt Ihnen, welcher Inhalt von Google als so irrelevant eingestuft wurde, dass er nicht einmal gecrawlt wurde.

Mögliche Gründer für Gefunden – zurzeit nicht indexiert sind daher:

- Sehr dünner und irrelevanter Content (Bspw.: URL mit Einzeiler "Wir sind in den Betriebsferien" im Blog)

- URLs, die gar nicht intern verlinkt werden und Google als sehr irrelevant erscheinen

- Generischer 0815 KI Content von ChatGPT der erstellt wurde, ohne einen Mehrwert zu bieten

- Leere Schlagwort- bzw. Tag- Seiten (websitexyz.de/tag/test123) im Überfluss, die keinerlei Mehrwert bieten

Überprüfen Sie die angegebenen URLs. Ggf. sollten Sie solche Inhalte entfernen oder gar Ihre Website-Struktur neu überdenken.

Nicht gefunden (404)

Nicht gefunden (404) ist ein Graus für die Indexierung bei Google. Denn ein 404 legt dem Crawler Steine in den Weg und weist auf einen echten Fehler hin. I.d.R handelt es sich um fehlerhafte interne Links oder externe Links (Backlinks).

Mögliche Ursachen für "Nicht gefunden (404)":

- Trailing Slash fehlt

- Veralteter Link

- Backlinks auf nicht (mehr) existierende Seiten

- Relaunch bzw. Umzug ohne Weiterleitung (301/302 fehlt)

- Fehlerhafte Sitemap

- u.v.m.

404s sollten nach Möglichkeit komplett vermieden werden, um den Crawlern den Weg zu ebnen. Überprüfen Sie die 404 in der GSC regelmäßig und korrigieren Sie diese sofort.

Soft 404

Ein Soft 404 in der Google Search Console ist relativ harmlos, wenn er nur selten vorkommt. Hierbei erkennt Google einen Inhalt, denkt jedoch, dass es sich um einen Fehler handelt, obwohl nicht direkt ein HTTP-Antwortcode 404 ausgegeben wird.

Bei einem Soft 404 handelt es sich meist um:

- Produkte in einem Onlineshop, die aktuell nicht vorrätig sind

- Produkte in einem Onlineshop, die aus dem Sortiment genommen wurden und bspw. der Preis fehlt

- URLs, die als 404-Seite dienen sollen und im Index sind. Allerdings im title und der h1 "404" stehen haben.

Überprüfen Sie die weichen 404s und passen Sie die URLs ggf. an.

Mehr dazu unter: 404 Fehler und SEO, 404 Fehler finden in der GSC und korrigieren/weiterleiten

Wegen eines anderen 4xx-Problems blockiert

Die Fehlermeldung Wegen eines anderen 4xx-Problems blockiert ist relativ selten und sollte bei Auftreten betrachtet werden.

Serverfehler (5xx)

Der Serverfehler (5xx) zeigt, dass es URLs gab, die nicht erreichbar waren und bspw. einen Server-Status 503 zurückgegeben haben.

Dies ist ein Indiz dafür, dass ggf. Ihr Hosting bzw. Ihr Server zum Zeitpunkt des Crawlings überlastet war, oder dass generell Ihr Server / Hosting etwas schwach ist.

Sollten Sie hier häufig Serverfehler erkennen, sollten Sie den Fehler bzw. die Performance analysieren. Ggf. muss ein Upgrade durchgeführt werden.

Duplikat – Google hat eine andere Seite als der Nutzer als kanonische Seite bestimmt

Der Hinweise Duplikat – Google hat eine andere Seite als der Nutzer als kanonische Seite bestimmt ist recht selbsterklärend. Denn er besagt, dass der von Ihnen bzw. der Website gesetzte Canonical-Tag nicht übernommen wurde und Google einen anderen Canonical verwendet.

Mögliche Ursachen für Duplikat – Google hat eine andere Seite als der Nutzer als kanonische Seite bestimmt:

- Technische Probleme

- Mögliche Fehler bei mehrsprachigen Seiten / automatisierte Übersetzung

- URLs bzw Seiten mit bzw. ohne Trailing-Slash im Canonical

Duplikat – vom Nutzer nicht als kanonisch festgelegt

Der Fehler Duplikat – vom Nutzer nicht als kanonisch festgelegt sagt, dass der Canonical Tag nicht oder nicht korrrekt verwendet wird und somit Duplicate Content bestehen kann. Um das zu vermeiden, sollte ermittelt werden, welche URL das Original ist und das mittels Canonical festgelegt werden.

Häufige kommt Duplikat – vom Nutzer nicht als kanonisch festgelegt vor bei:

- Produkten oder Kategorien mit URLs Filter, oder Sortierungen (?category_id=567&sort_order=desc)

- Produkten mit verschiedenen Varianten (Größe, Farbe etc.)

Untersuchen Sie die angegebenen URLs und korrigieren Sie diese einzeln oder direkt mit Ihren Systemeinstellungen, um solche Fehler zu vermeiden.

Tipp: Ihr Unternehmen braucht SEO-Unterstützung? Ich analysiere, berate und optimiere direkt.

Lassen Sie uns in einem unverbindlichen Erstgespräch über Ihr Projekt sprechen.

Wegen Zugriffsverbot (403) blockiert

Die Fehlermeldung Wegen Zugriffsverbot (403) blockiert zeigt, dass der Googlebot keinen Zugriff erlaubt bekommt. Sollte bspw. in der robots.txt folgender Code stehen, hätte der Googlebot keinen Zugriff auf die angegebene /url-123.

User-Agent: GooglebotÜberprüfen Sie die robots.txt, um nur irrelevante Inhalte vom Crawling und Indexierung auszuschließen.Disallow: /url-123

Alternative Seite mit richtigem kanonischen Tag

Alternative Seite mit richtigem kanonischen Tag habe ich bereits im Glossar erklärt.

Den Beitrag finden Sie unter Alternative Seite mit richtigem kanonischen Tag.

Umleitungsfehler

Die Fehlermeldung Umleitungsfehler wird auch Weiterleitungsfehler genannt und zeigt an welche URLs nicht indexiert werden können.

Mögliche Gründer für Umleitungsfehler / Weiterleitungsfehler:

- Weiterleitungsketten von URL A zu B zu C zu D zu E. Diesen Ketten möchte der Crawler nicht folgen.

- Weiterleitungsschleifen von URL A zu B zu A zu B ... Somit ist die URLs niemals erreichbar. .

Umleitungsfehler sind - wenn Sie nur auf der eigenen Website bzw. Shop vorkommen - gut behebbar. Analysieren Sie die URLs und korrigieren Sie alle Fehler bei den Weiterleitungen.

Wegen nicht autorisierter Anforderung (401) blockiert

Die Meldung Wegen nicht autorisierter Anforderung (401) blockiert bedeutet, dass Google bzw. der Googlebot die Seite nicht erreichen bzw. lesen kann, weil diese durch ein Passwort geschützt ist.

Prinzipiell ist diese Meldung irrelevant, sollte in der Übersicht nur Ihnen bekannte URLs vorkommen, die tatsächlich nur für eingeloggte Nutze sichtbar sind. Sollte dies nicht der Fall sein, lohnt sich eine SEO-Analyse mit dem Fokus auf technische SEO.

Als SEO-Experte uns SEO-Freelancer für Unternehmen habe ich bereits alle der obenstehenden Probleme lösen dürfen, um die Indexierung bei Google zu ermöglichen. Sollten Sie Hilfe mit technischer SEO und der Indexierung bei Google benötigen, melden Sie sich gerne.

Sie möchten unverbindlich über eine Zusammenarbeit sprechen?

Vereinbaren Sie gerne ein Erstgespräch.

Als SEO-Freelancer und SEO-Experte arbeite ich für diverse Unternehmen und habe bereits alle der obenstehenden Probleme lösen können, um die Indexierung bei Google zu ermöglichen. Häufig reicht ein Blick in die GSC, gelegentlich muss jedoch eine SEO Analyse erstellt werden mit dem Fokus auf technische SEO und die Crwalbarkeit und Indexierbarkeit der Inhalte. Denn nur wenn Inhalte erreichbar und auslesbar sind für Googlebot und Co. können diese im Index der Suchmaschinen landen und eingeordnet bzw. gerankt werden.

Sollten Sie Probleme mit der Indexierung bei Google habe stehe ich gerne zur Verfügung für Ihr Unternehmen.

Ich hoffe, dass ich Ihnen hier durch meinen Beitrag Fragen wie "Warum wird meine Seite nicht bei Google gefunden" benatwortet werden. Sollten Sie weitere Probleme in der GSC finden, die ich hier nicht bezürlich der Indexierung genannt bzw. besprochen habe, lassen Sie es mich gerne kurz wissen.

Häufige Fragen & Antworten zur Indexierung in der GSC

Neue Gründe verhindern die Indexierung von Seiten auf der Website

Haben Sie eine E-Mail erhalten mit dem Betreff "Neue Gründe verhindern die Indexierung von Seiten auf der Website"? Dann finden Sie hier im Beitrag auch die passenden Erklärungen und Lösungen zu den im Bereich "Neuer Grund dafür, dass Seiten nicht indexiert werden" oder "Neue Gründe dafür, dass Seiten nicht indexiert werden" angesprochenen Gründen. Auch wenn es sich bei gut optimierten Websites häufig um falschen Alarm handelt, sollten Sie die Gründe analysieren und ggf. handeln.

Was bedeutet nicht indexiert?

Nicht indexiert bedeutet, dass eine URL nicht im Index von - in diesem Beispiel Google - ist. Anders gesagt kann eine Seite die nicht indiziert ist auch nicht in der Suche erscheinen.

Manchmal ist das gewünscht, manchmal jedoch nicht.